W 1989 roku pracownik naukowy LBL Bill Johnston został wezwany do Waszyngtonu na przesłuchanie w Senacie Stanów Zjednoczonych. Jego celem było zbadanie potencjału krajowej superautostrady informacyjnej.

Johnston i jego koledzy pokazali Waszyngtonowi przyszłość. Podczas pierwszej w historii demonstracji komputerowej przeprowadzonej na żywo przed przesłuchaniem w Senacie, pokazali oni możliwości szybkiej, transkontynentalnej sieci komputerowej. Naukowcy podłączyli komputer i wyświetlili dane przetworzone, przeanalizowane i zmontowane w animowane „filmy” naukowe przez urządzenia i badaczy rozmieszczonych tysiące mil od siebie. Zademonstrowali, jak urządzenia takie jak rezonans magnetyczny, superkomputery, urządzenia do przechowywania danych i stacje robocze komputerów mogą być tymczasowo połączone razem, łącząc osoby i zasoby w sposób, który nigdy wcześniej nie był możliwy.

IMAGE OF INTERNET TRAFFIC ON NSFNET T1 BACKBONE |

Cztery lata później prezydent Bill Clinton i wiceprezydent Al Gore, który jako senator przewodniczył przesłuchaniu w 1989 roku, polecieli do kalifornijskiej Doliny Krzemowej. Spotkali się w Silicon Graphics Inc. i zostali poinformowani o stanie powstającej superautostrady informacyjnej, a następnie podzielili się swoją wizją jej przyszłości. Gore był orędownikiem tego projektu od jego początków.

W przeddzień wizyty Clintona i Gore’a, Andrew Cherenson z Silicon Graphics wysłał pod wpływem impulsu wiadomość o rozprzestrzeniającej się, przypominającej pajęczynę sieci komputerowej, która obecnie łączy wiele instytucji akademickich i badawczych na całym świecie: Czy ktoś jest zainteresowany konferencją Clinton/Gore? Zalogowawszy się później, sprawdził odpowiedź. Następnego ranka Cherenson podłączył minikamerę Sony i towarzyszył Clintonowi i Gore’owi podczas ich sesji burzy mózgów z planistami i graczami, którzy pomagają w budowie superautostrady informacyjnej. Na całym świecie 200 zachwyconych „uczestników” siedziało przy swoich biurkach przed stanowiskami komputerowymi, obserwując wydarzenia w Silicon Graphics i komentując je między sobą. Improwizowana wideokonferencja Cherensona – zwiastun łatwości, z jaką będziemy mogli rozmawiać, odwiedzać się i dzielić informacjami w niedalekiej przyszłości – była transmitowana w 11 krajach i 22 strefach czasowych.

Dziesięć lat temu, taka komunikacja była konwencjonalna w świecie science fiction, ale nowa i obca jako cel polityki krajowej. Począwszy od 1968 roku, rząd federalny poprzez swoją Agencję Zaawansowanych Projektów Badawczych w Obronie (DARPA) zapewnił fundusze zalążkowe na stworzenie najpierw jednej, a następnie kilku eksperymentalnych sieci, które mogłyby przesyłać dane między instytucjami badawczymi z dużą prędkością. Te prototypowe sieci rozwinęły się, rozprzestrzeniły i szybko połączyły. Dzisiaj, połączona infrastruktura ponad 11 000 sieci znana jako Internet, lub po prostu „sieć”, łączy ponad 10 milionów ludzi na całym świecie.

Od samego początku Lawrence Berkeley Laboratory było jednym z głównych architektów obliczeń sieciowych, pomagając „rozwijać sieć” od 1972 roku. LBL „weszło na antenę” w 1975 roku, stając się jedną z niewielu instytucji podłączonych do sieci. Kiedy w 1986 roku Internet przeciążył się, ugrzązł i był na skraju samozniszczenia, naukowiec z LBL, Van Jacobson, był członkiem dwuosobowego zespołu, który pomógł go uratować, ocalić przed tymi, którzy zalecali jego porzucenie. Ostatnio Jacobson i jego zespół wnieśli inny kluczowy wkład, dokonując metamorfozy tego, co wcześniej było potokiem danych i poczty elektronicznej, w sieć, która obecnie umożliwia wielu ludziom natychmiastową rozmowę i interakcję poprzez sieciowe konferencje audio i wideo. Dziś ta zdominowana przez pocztę kultura rozkwita, pozwalając ludziom z całego świata na rutynowe interakcje, tak jak miało to miejsce podczas wizyty Clintonów/Gore’ów w Silicon Graphics. LBL jest również pionierem w dziedzinie rozproszonych obliczeń naukowych, wykuwając nowe połączenia, które sprawiają, że lokalizacja drogich zasobów obliczeniowych staje się nieistotna.

Patrząc na to, co zostało osiągnięte i co jest w trakcie realizacji, dyrektor Wydziału Informatyki i Nauk Obliczeniowych LBL Stu Loken mówi, że jesteśmy u progu nowej ery informacji.

„Rząd federalny ma długą historię inwestowania w infrastrukturę narodową”, zauważa Loken. „Zbudował kanały w XVIII wieku, linie kolejowe w XIX wieku i autostrady międzystanowe w XX wieku. Następnie, około 10 lat temu, rozpoczęto budowę szybkich sieci komputerowych. Sieci te są autostradami Wieku Informacji.”

Loken i prawie każdy inny badacz w tej dziedzinie mówią, że superautostrady informacyjne spowodują nieuchronną konwergencję telewizji, telefonu, telewizji kablowej, komputerów, elektroniki użytkowej, wydawnictw i przedsiębiorstw informacyjnych w jeden interaktywny przemysł informacyjny. Wiceprezydent Gore przewiduje, że będzie to „najważniejszy i najbardziej lukratywny rynek XXI wieku”. AT&T twierdzi, że spodziewa się, iż światowy rynek informacyjny będzie wart 1,4 bln USD do 1996 r.; Apple Computer szacuje, że do roku 2001 rynek wzrośnie do 3,5 bln USD.

Wizja superautostrad informacyjnych prawie rozbiła się w 1986 roku.

Wówczas, mając prawie dwie dekady, Internet miał 10 000 użytkowników. Zaczęli oni polegać na sieci, ponieważ stała się ona już czymś więcej niż tylko środkiem do wymiany poczty elektronicznej i przenoszenia danych. Sieć służyła jako wirtualny korytarz biurowy, intymnie łączący odległych współpracowników.

W październiku 1986 roku, Internet doświadczył tego, co jego wielu projektantów zdiagnozowało jako „załamanie zatoru”. Komunikacja – cyfrowy strumień danych składający się ze wszystkiego, od pisemnych wiadomości po surowe dane naukowe – przepływała przez system z prędkością do 56 kilobitów na sekundę (56 000 bitów, czyli około dwóch stron maszynopisu, na sekundę). Pewnego dnia ten system informacyjny XXI wieku nagle zwolnił do tempa telegrafu. Tego dnia szybkość transmisji między Laboratorium Lawrence’a Berkeleya a Uniwersytetem Kalifornijskim w Berkeley, oddalonym o ćwierć mili, spadła do 320 bitów na sekundę. Użytkownicy systemu byli zdumieni i przerażeni.

Internauci w całym kraju, tak samo zależni od sieci jak większość z nas od naszych telefonów, zastanawiali się, jak ją ożywić. Van Jacobson z Wydziału Inżynierii LBL był wśród tych, którzy się zaangażowali.

„Sieć zwolniła o współczynnik tysiąca”, wspomina Jacobson. „Poczta, która wcześniej przechodziła w ciągu kilku minut, teraz zajmowała cały dzień. Ludzie zaczęli z tego rezygnować. Cała idea komunikacji sieciowej była zagrożona”.

„Pracowałem z Mike’em Karelsem (z Berkeley Unix Development Group na Uniwersytecie Kalifornijskim w Berkeley). Przez sześć miesięcy zastanawialiśmy się, dlaczego Internet zawodzi, bijąc głową w mur. Aż pewnego wieczoru w kawiarni w Berkeley nastąpił moment oświecenia. Odwróciliśmy pytanie. Prawdziwe pytanie brzmiało: „Jak Internet kiedykolwiek działał?”.

„Pomyśl o tym”, mówi Jacobson: Stacja robocza może przesyłać dane z prędkością 10 megabitów na sekundę (10 milionów bitów), a router umieszcza je w Internecie, który ma przepustowość 56 kilobitów na sekundę. Zaczynamy od tego wąskiego gardła, a potem musimy zmagać się z tysiącami ludzi korzystających z sieci jednocześnie. Biorąc to pod uwagę, mówi, korek w Internecie było nieuniknione.

Jak ruch wzrósł w Internecie, system wielu użytkowników polegał na tym, co równało się autodestrukcyjne zachowanie w ich próbach przebicia się przez impas sieci. Pakiety informacji byłyby przesyłane do sieci przez komputer, a następnie zwracane do nadawcy z powodu przeciążenia. Komputery były zaprogramowane tak, by radzić sobie z tym problemem, natychmiast próbując ponownie, wielokrotnie przesyłając wiadomość, aż do skutku. Jacobson porównuje tę sytuację do polewania ognia benzyną.

JAK PACZKI WYSYŁANE POCZTĄ, KOMUNIKATY PRZESYŁANE PRZEZ SIEĆ SĄ DZIELONE NA MAŁE PAKIETY I OPAKOWYWANE W INSTRUKCJE WYSYŁKI I MONTAŻU, NAZYWANE PROTOKOŁAMI |

Rozwiązaniem, jak twierdzi, było sprawienie, aby użytkownicy sieci byli bardziej uprzejmi.

„Jeśli zbyt wiele osób próbuje komunikować się jednocześnie”, wyjaśnia Jacobson, „sieć nie może sobie z tym poradzić i odrzuca pakiety, odsyłając je z powrotem. Gdy stacja robocza natychmiast retransmituje, pogarsza to sytuację. To, co zrobiliśmy, to napisanie uprzejmych protokołów, które wymagają niewielkiego oczekiwania, zanim pakiet zostanie retransmitowany. Wszyscy muszą używać tych uprzejmych protokołów, inaczej Internet nie będzie działał dla nikogo.”

Protokoły Jacobsona i Karelsa, stanowiące obecnie uniwersalną część Internetu, noszą nazwę „Slow Start.” Slow Start unika zatorów poprzez monitorowanie sieci i, gdy zator wydaje się nieuchronny, opóźnianie transmisji pakietów w dowolnym miejscu od milisekund do sekundy. Slow Start opóźnia transmisję w oparciu o czynniki, które obejmują bieżącą dostępną przepustowość sieci, jak również wielokrotność czasu transmisji w obie strony (zasadniczo odległość) pomiędzy nadawcą a wybranym miejscem docelowym. Sześć lat po wprowadzeniu Slow Start nadal zapobiega przeciążeniu sieci, mimo że zarówno szybkość sieci, jak i liczba użytkowników wzrosły tysiąckrotnie.

Około dwa lata temu Jacobson i naukowcy z Xerox’s Palo Alto Research Center (PARC) podjęli się realizacji projektu mającego na celu dodanie do Internetu konferencji audio i wideo. Podobnie jak w przypadku systemów telefonicznych, konferencje audio/wideo pomiędzy wieloma stronami za pośrednictwem komputera były starą, ale nieosiągalną wizją.

W kategoriach konferencji, sieć komputerowa zaczyna z nieodłączną przewagą nad systemem telefonicznym. Podczas gdy linia telefoniczna łączy dwa punkty i przenosi jedną rozmowę, Internet łączy każdą stronę na linii i przenosi wiele jednoczesnych „rozmów”. Aby obsłużyć ten ogromny przepływ informacji, rozbija komunikację na małe pakiety, które są mieszane w ciągłym strumieniu pakietów przemierzających sieć. Każdy pakiet jest opakowany w instrukcje wysyłkowe i montażowe (zwane protokołami), które podają miejsce przeznaczenia, adres zwrotny i sposób, w jaki komputer odbierający może zmienić kolejność wszystkich pakietów z powrotem do oryginalnej komunikacji.

Z powodu niewielkich opóźnień charakterystycznych dla Internetu kilka grup badawczych, którym powierzono zadanie wprowadzenia do sieci konferencji audio i wideo, doszło do wniosku, że otrzymały misję niemożliwą do wykonania. Poradzili, aby zbudować nową sieć.

„Uważaliśmy, że to niedorzeczne”, wspomina Jacobson. „Internet obsługiwał komunikację między dwoma superkomputerami Cray, które transmitują z prędkością jednego gigabita na sekundę (jednego miliarda bitów). Działał też dla kogoś siedzącego przy klawiaturze, piszącego z prędkością 20 bitów na sekundę. Ta solidność i dynamika wydawała się zbyt dobra, by z niej zrezygnować. Przyjrzeliśmy się więc uważnie. Nie powinno być powodu, dla którego nie moglibyśmy zrobić audio i wideo”.

Opóźnienia faktycznie bardziej przeszkadzają ludziom rozmawiającym niż w przypadku wideokonferencji. Uczestnicy konferencji mogą tolerować sporadyczne nieruchome obrazy podczas transmisji wideo, podczas gdy głosy słyszane w nierównych zrywach staccato brzmią jak bełkot. Jacobson i Steve Deering z Xerox PARC skupili się na opracowaniu systemu, który zachowałby globalną łączność Internetu, a jednocześnie umożliwiłby płynny i szybki przepływ dźwięku.

Aby umożliwić słuchaczowi słuchanie ciągłej mowy, Jacobson i Deering najpierw dodali znacznik czasu do każdego pakietu audio. Odbiornik odczytuje znaczniki czasu, porządkuje chronologicznie pakiety, a następnie odtwarza je, jednocześnie kontynuując odbieranie i zamawianie dodatkowych przychodzących pakietów do późniejszego odtworzenia. To pozwala na uniknięcie wewnątrz-na zewnątrz mowy Pig Latin, ale nie radzi sobie z nierówną naturą przepływu pakietów sieciowych i wybuchów dźwięku, które są tego wynikiem.

Aby temu zaradzić, dwaj badacze wykorzystali różnicę pomiędzy niesamowitą prędkością, z jaką sieć przenosi pakiety, a stosunkowo długim, dwutysięcznym lub półsekundowym opóźnieniem, które ludzie mogą znieść bez zakłócania rozmowy. Stworzyli oni algorytm, który oblicza, ile czasu zajmuje dotarcie pakietów, a następnie spowalnia odtwarzanie głosu na tyle, aby nawet najwolniejsze pakiety miały wystarczająco dużo czasu na dotarcie. Opóźnienia odtwarzania wprowadzone przez algorytm są w rzeczywistości bardzo krótkie, zazwyczaj mniejsze niż jedna dziesiąta sekundy. Dzięki niezauważalnym, kontrolowanym opóźnieniom wprowadzonym przez Jacobsona i Deeringa, konferencje głosowe pomiędzy użytkownikami Internetu wyposażonymi w mikrofony i głośniki komputerowe są teraz powszechne.

Siedząc w swoim biurze w LBL, Jacobson zademonstrował, w jaki sposób jest połączony z sieciowcami na całym świecie. Logując się do Internetu, wywołał Lightweight Sessions, interfejs okienkowy z prostym formularzem do ogłaszania lub zapisywania się na konferencję audio lub wideo. Użytkownicy sieci rutynowo korzystają z Lightweight Sessions, aby uzyskać informacje o nadchodzących konferencjach i zapisać się na te, które ich interesują. Niektóre konferencje są tylko głosowe, podczas gdy inne obejmują wideo, które zostało opracowane przez naukowców Xerox PARC. Podczas konferencji audio/wideo małe, niedrogie kamery, zwykle podłączone do boku komputera uczestnika, przekazują na żywo obraz każdego z uczestników. Ekran Jacobsona był podzielony na wiele okien, z których jedno pokazywało obraz osoby przemawiającej. W drugim oknie wyświetlane były dane, które były przedmiotem dyskusji. Trzecie okno ma zadebiutować w Internecie w najbliższej przyszłości.

Jacobson nazywa to nowe graficzne okno wyświetlania „tablicą”. Ludzie będą mogli korzystać z niego podobnie jak z konwencjonalnego programu do rysowania na komputerze, aby dzielić się informacjami lub współpracować przy projektach. Każdy uczestnik konferencji może zobaczyć, a następnie zmodyfikować to, co jest przedstawione na tablicy lub cofnąć się do poprzedniej wersji obrazu. Dowolny obraz – na przykład projekty wspomagane komputerowo lub zdjęcia rentgenowskie – również może być importowany do okna tablicy.

Tablica jest wskaźnikiem rosnącego znaczenia danych wizualnych w nauce.

Stu Loken mówi, że obrazy nieruchome i wideo będą integralną częścią większości badań prowadzonych w LBL. „Nauka doświadcza proliferacji danych wizualnych, wszystko od map nieba przedstawiających strukturę wczesnego wszechświata do obrazów medycznych pokazujących neurochemię u pacjentów z chorobą Alzheimera, do obrazów ludzkiego genomu,” mówi.

Loken przyznaje, że obrazy stwarzają zarówno możliwości, jak i problemy. Do tworzenia obrazów potrzebne są ogromne ilości informacji cyfrowych: Kamera wideo generuje 30 klatek na sekundę, czyli odpowiednik ponad 2000 stron słów. Ale komputery są teraz wystarczająco szybkie, a urządzenia pamięci masowej wystarczająco masywne, tak że naukowcy zaczynają używać kamer wideo, przechwytując dane do analizy komputerowej. Ten pojawiający się potencjał powoduje zmianę w sposobie, w jaki naukowcy projektują eksperymenty, otwierając nowe okna na to, czego można się nauczyć.

Aby umożliwić naukowcom tworzenie danych za pomocą wideo, naukowcy z Wydziału Informatyki LBL podjęli się wieloaspektowej misji. Bill Johnston kieruje zespołem, który tworzy nowy sprzęt i oprogramowanie do przetwarzania i analizy strumienia danych wizualnych w szybkich sieciach. Chodzi o to, by naukowiec mógł pobrać dane wyjściowe na przykład z mikroskopu elektronowego i podłączyć ten strumień wideo do sieci tak samo rutynowo, jak dziś można podłączyć do sieci stację roboczą.

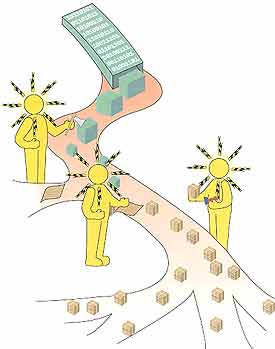

Podłączenie do sieci to tylko pierwszy krok. Grupa Johnstona zajmuje się rozwojem rozproszonych obliczeń naukowych. Do tej pory lokalizacja zasobów dyktowała kierunek rozwoju nauki. Projekty są realizowane w miejscach, gdzie można zgromadzić odpowiednich ludzi, eksperymenty i zasoby obliczeniowe. W rozproszonych naukowych środowiskach obliczeniowych, których pionierem jest obecnie LBL, maszyny, bazy danych i ludzie rozproszeni po całym świecie mogą być szybko i tymczasowo połączeni. Na przykład, strumień wideo z trwającego eksperymentu może zostać skierowany do superkomputera w celu przetworzenia, a natychmiastowa analiza wykorzystana do interaktywnego sterowania aparaturą eksperymentalną. Lub przepływ danych może być przetwarzany, analizowany, a następnie służyć jako dane wejściowe w towarzyszącym eksperymencie.

Johnston zauważa, że sieciowe wideokonferencje są już dostępne, ale ostrzega, że nie należy ich mylić z szybką transmisją sieciową naukowych danych wideo. Różnica polega na jakości obrazu.

Na przykład, aby przecisnąć transmisje wideokonferencji przez wciąż wąski rurociąg internetowy, standardowa szybkość transmisji 30 klatek na sekundę została zredukowana do sześciu do 12 klatek na sekundę. Dodatkowo, zamiast transmitować kolejne pełne klatki, stosuje się algorytmy kompresji, które transmitują tylko tę część obrazu, która uległa zmianie w stosunku do poprzedniej klatki. Te częściowe obrazy są następnie łączone w pełne obrazy przez oprogramowanie po stronie odbiorczej. Efektem netto jest to, że ludzie mogą widzieć przyzwoite obrazy siebie nawzajem podczas rozmowy, nawet jeśli szybkość przepływu cyfrowego jest zmniejszona tysiące razy w stosunku do standardowej transmisji wideo.

Ale to działa dla wideokonferencji — poczucie obecności jest tworzone, jeśli nie jest to obraz jakości Ansela Adamsa — dane naukowe nie mogą być skoncentrowane w ten sposób i przetrwać.

Wyjaśnia Johnston, „Dane wideo zazwyczaj składają się z obrazów produkowanych przez czujniki, które przesuwają granice technologii. Często mamy wiele rozmytych, mało kontrastowych obrazów z cechami, które są trudne do odróżnienia od szumu tła. Aby móc analizować i wydobywać informacje, nie możemy sobie pozwolić na utratę jakichkolwiek szczegółów oryginalnego obrazu wideo. Wideo przesyłane przez Internet zostało skompresowane do 8-16 kilobitów na sekundę. Porównaj to z konwencjonalną monochromatyczną kamerą instrumentacyjną, która generuje 120 000 kilobitów na sekundę.”

Grupa Johnstona wykorzystuje nauki laboratoryjne jako siłę napędową do rozwoju technologii przeznaczonej ostatecznie dla mas. Na przykład, rozważmy przypadek biochemika z LBL Marcosa Maestre, który nagrywa na wideo małe pasma DNA wibrujące w mikroskopijnej sieci elektrycznej, aby zbadać fizyczną chemię DNA. Obecnie badacze wibrują DNA, tworzą taśmę wideo, a następnie przekazują ją do systemu animacji, gdzie żmudnie tworzone są obrazy każdej klatki. Godziny i godziny są wymagane, aby wyodrębnić około 200 klatek, czyli siedem sekund danych. Następnie obrazy są skanowane do komputera klatka po klatce, który śledzi i mierzy zmieniający się kształt łańcucha DNA, uzyskując nowy wgląd w jego strukturę.

W rozproszonym systemie opracowywanym w LBL, naukowcy będą mogli spojrzeć na monitor stacji roboczej i zobaczyć dane zebrane z wideo na żywo, nawet w trakcie trwania eksperymentu. Kamera wideo będzie podłączona do sieci, gdzie urządzenie magazynujące będzie zapisywać obrazy, jednocześnie przekazując je do nowego superkomputera w LBL, masywnie równoległego systemu przetwarzania MasPar. MasPar może przetwarzać i analizować obraz wideo z prędkością 30 klatek na sekundę, zapewniając natychmiastowe wyświetlanie danych na każdej stacji roboczej inżyniera w sieci.

Niestety, aby to urzeczywistnić, trzeba czegoś więcej niż tylko podłączyć komponenty tego systemu do siebie. W miarę jak cyfrowy strumień przepływa z eksperymentu do miejsca jego przechowywania, analizy i wyświetlania, pojawia się kilka wąskich gardeł. Zanim surowy sygnał płynący z kamery monochromatycznej z prędkością 120 000 kilobitów na sekundę zostanie przesłany do sieci, komputer pośredniczący musi przetłumaczyć dane wyjściowe na pakiet cyfrowy skonfigurowany dla sieci. Na tym etapie ruch cyfrowy zaczyna się cofać.

„Kiedy jedynym powodem istnienia komputera jest pośredniczenie między siecią a kamerą”, komentuje Johnston, „w efekcie stworzyłeś biurokrację. Komputer wykonuje swoją pracę, ale nieefektywnie. Komputer jest zaprojektowany do wykonywania wielu zadań, a nie tego specjalistycznego zadania. Potrzebujemy kontrolera, czyli uproszczonego komputera przeznaczonego tylko do tego jednego zadania. Obecnie budujemy kontroler sieciowy dla kamery wideo we współpracy z firmą PsiTech Corp. z Fountain Valley, Kalifornia.”

Ogrywanie biurokratów i otwieranie wąskich gardeł — Johnston mówi, że jest to powtarzająca się misja jego grupy zajmującej się obliczeniami rozproszonymi. Na przykład, dane przesyłane przez sieć muszą być zapisywane w cyfrowym archiwum, zanim zostaną przeanalizowane. Aby przechowywać duże ilości danych pochodzących z takich źródeł jak wideo, na kampusie Berkeley opracowano Redundant Arrays of Inexpensive Disks (RAID). Pierwsza generacja RAID wymagała komputera pośredniczącego, co spowalniało przepływ danych, dlatego zbudowano kontroler sieciowy i opracowano nową generację, RAID II. RAID II został już podłączony do HiPPI, sieci o przepustowości 800 megabitów na sekundę, używanej zazwyczaj do łączenia superkomputerów, a LBL pracuje nad podłączeniem go do Internetu. Prace te są wynikiem współpracy kilku grup z dziedziny inżynierii elektrycznej i informatyki. W powiązanym projekcie finansowanym przez Departament Energii, grupa Johnstona współpracuje z profesorami z Berkeley: Domenico Ferrari i Randy Katz oraz Bobem Finkiem i Tedem Sopherem z LBL przy budowie światłowodowej sieci gigabitowej (miliard bitów), która łączy LBL z kampusem Berkeley. Cały sprzęt o dużej prędkości w LBL i na kampusie został podłączony do tej sieci, tworząc lokalną odnogę do krajowej superautostrady informacyjnej.

W LBL, nowy komputer MasPar będzie odgrywał główną rolę w rozproszonym środowisku obliczeniowym laboratorium, otwierając drzwi do ery danych wizualnych. Choć pozwoli on na tworzenie i przechowywanie dużej ilości obrazów, badacze wkrótce napotkają na poważną przeszkodę. Nawet przy 4096 procesorach zapewniających szczytową wydajność 17 000 milionów instrukcji na sekundę, nikt jeszcze nie wie, jak poinstruować superkomputer, by znalazł konkretny zapisany obraz.

„Przeszukiwanie tekstowej bazy danych w poszukiwaniu słowa lub ciągu znaków i przeszukiwanie bazy danych wideo w poszukiwaniu obiektu to zupełnie inne problemy”, mówi Johnston. „Komputer z łatwością może znaleźć każde odniesienie w tekstowej bazie danych do `ryby’, ale nie ma gotowego sposobu, aby przejrzeć archiwalny zestaw obrazów wideo i znaleźć wszystkie te, na których jest ryba. Współpracujemy z MasPar Computer Corporation, aby opracować technologię, która to umożliwi.”

Symbolizm tej misji – przeszukiwanie przysłowiowego stogu siana obrazów i, w końcu, znalezienie igły – nie powinien być przeoczony. Dla informatyków z LBL jest to czas nieuchronnie zbliżających się możliwości.

Ruch w Internecie jest coraz szybszy, a nowe ostrogi rosną i łączą się. Odkąd Clinton i Gore objęli urząd, ogłoszono kaskadę wielomiliardowych inwestycji korporacyjnych w infrastrukturę sieciową. Firmy telefoniczne, telewizji kablowej i telefonii komórkowej, wydawcy i producenci komputerów spieszą się, by wysunąć swoje roszczenia. Ameryka jest podłączana do sieci przyszłości.

Mówiąc w imieniu swoich kolegów, Johnston mówi: „Czekają nas w tym kraju zmiany tak głębokie, jak te, których doświadczyli nasi przodkowie na początku rewolucji przemysłowej. W ciągu najbliższej dekady komputery, komunikacja i rozrywka zostaną połączone. Naukowcy, lekarze, ludzie biznesu i uczniowie będą połączeni nie tylko ze swoimi rówieśnikami, ale ze wszystkimi innymi. Sposób, w jaki się uczymy i współdziałamy, wkrótce zostanie zrewolucjonizowany.”

.