I 1989 blev LBL-forskeren Bill Johnston kaldt til Washington for at deltage i en høring i det amerikanske Senat. Formålet: at undersøge potentialet i en national informationssuperhighway.

Johnston og hans kolleger viste Washington fremtiden. Under den første live-computerdemonstration, der nogensinde er blevet gennemført foran en høring i Senatet, viste de mulighederne for et transkontinentalt computernetværk med høj hastighed. Forskerne tilsluttede en computer og viste data, der blev behandlet, analyseret og sat sammen til animerede videnskabelige “film” af apparater og forskere, der var fordelt tusindvis af kilometer fra hinanden. De demonstrerede, hvordan udstyr som f.eks. en magnetisk resonansafbildningsenhed, supercomputere, datalagringsenheder og computerarbejdspladser midlertidigt kunne forbindes med hinanden og forbinde personer og ressourcer på en måde, der aldrig tidligere har været mulig.

BILLEDE AF INTERNETTRAFIK PÅ NSFNET T1 BACKBONE |

Fire år senere fløj præsident Bill Clinton og vicepræsident Al Gore, som som som senator havde været formand for høringen i 1989, til Silicon Valley i Californien. De mødtes hos Silicon Graphics Inc. og blev orienteret om status for den nye informationssuperhighway og delte på skift deres visioner for dens fremtid. Gore har været fortaler for dette projekt siden dets spæde begyndelse.

Af før besøget mellem Clinton og Gore sendte Andrew Cherenson fra Silicon Graphics en spontan besked om et spindelvævslignende computernetværk, der nu forbinder mange akademiske institutioner og forskningsinstitutioner rundt om i verden: Er der nogen, der er interesseret i Clinton/Gore-konferencen? Da han loggede ind senere, tjekkede han svaret. Den næste morgen tilsluttede Cherenson et Sony-minikamera og fulgte med Clinton og Gore under deres brainstorming-session med de planlæggere og aktører, der er med til at bygge informationssupervejen. Rundt om i verden sad 200 begejstrede “deltagere” ved deres skriveborde foran computerarbejdspladser og fulgte med i begivenhederne på Silicon Graphics, mens de kommenterede indbyrdes. Cherensons improviserede videokonference – et forvarsel om den lethed, hvormed vi i den nærmeste fremtid vil kunne tale sammen, besøge hinanden og udveksle oplysninger – blev transmitteret i 11 lande og 22 tidszoner.

For ti år siden var en sådan kommunikation konventionel inden for science fiction-verdenen, men ny og fremmedartet som et nationalt politisk mål. Fra 1968 stillede den føderale regering gennem sit Defense Advanced Research Projects Agency (DARPA) startkapital til rådighed for at etablere først et og siden flere eksperimentelle netværk, der kunne overføre data mellem forskningsinstitutioner med høj hastighed. Disse prototype-netværk har udviklet sig, spredt sig og er hurtigt blevet forbundet. I dag er der en sammensmeltet infrastruktur af mere end 11.000 net, kendt som internettet eller blot “nettet”, der forbinder over 10 millioner mennesker verden over.

Fra starten har Lawrence Berkeley Laboratory været en af de vigtigste arkitekter inden for netværkscomputere og har siden 1972 hjulpet med at “dyrke nettet”. LBL “gik i luften” i 1975 og blev en af en håndfuld institutioner, der var tilsluttet netværket. Da internettet blev overbelastet, gik i stå og var på randen af selvdestruktion i 1986, var LBL-forskeren Van Jacobson en del af et to-mands-team, der hjalp med at redde det og reddede det fra dem, der anbefalede, at det skulle opgives. På det seneste har Jacobson og hans hold ydet andre vigtige bidrag, idet de har udviklet metamorfosen af det, der havde været en data- og e-mail-rørledning, til et netværk, der nu giver mange mennesker mulighed for at tale og interagere øjeblikkeligt via lyd- og videonetværkskonferencer. I dag blomstrer denne tidligere mail-dominerede kultur og giver mennesker over hele verden mulighed for at interagere rutinemæssigt, ligesom de gjorde under Clinton/Gore Silicon Graphics-besøget. LBL er også en pioner inden for distribueret videnskabelig databehandling og skaber nye forbindelser, som gør det uvæsentligt, hvor dyre databehandlingsressourcer befinder sig.

Med hensyn til det, der er blevet opnået, og det, der er på vej, siger LBL’s direktør for Information and Computing Sciences Division Stu Loken, at vi står ved begyndelsen af en ny informationsalder.

“Den føderale regering har en lang historie med investeringer i landets infrastruktur”, bemærker Loken. “Den byggede kanaler i det 18. århundrede, jernbaner i det 19. århundrede og motorveje mellem stater i det 20. århundrede. For ca. 10 år siden begyndte den så at opbygge højhastighedscomputernetværk. Disse net er informationsalderens motorveje.”

Loken og næsten alle andre forskere på området siger, at informationssupermotorvejene vil resultere i den uundgåelige sammenlægning af tv, telefon, kabel-tv, computer, forbrugerelektronik, forlag og informationsvirksomheder til en enkelt interaktiv informationsindustri. Vicepræsident Gore forudsiger, at dette vil blive “den vigtigste og mest lukrative markedsplads i det 21. århundrede”. AT&T siger, at det forventer, at det globale informationsmarked vil være 1,4 billioner dollars værd i 1996; Apple Computer anslår, at markedet vil vokse til 3,5 billioner dollars i år 2001.

Visionen om informationssupermotorveje var nærmest gået i vasken i 1986.

Dengang var internettet næsten to årtier gammelt og havde 10.000 brugere. De var blevet afhængige af nettet, for det var allerede blevet meget mere end blot et middel til at udveksle elektronisk post og flytte data. Netværket fungerede som en virtuel kontorgang, der forbandt fjerntliggende samarbejdspartnere intimt.

I oktober 1986 oplevede internettet det, som dets mange designere diagnosticerede som “overbelastningskollaps”. Kommunikation – en digital datastrøm bestående af alt fra skriftlige meddelelser til rå videnskabelige data – var strømmet gennem systemet med op til 56 kilobit pr. sekund (56.000 bits, eller ca. to maskinskrevne sider, pr. sekund). Så en dag bremsede dette informationssystem fra det 21. århundrede pludselig op til telegrafens hastighed. Den dag faldt overførselshastigheden mellem Lawrence Berkeley Laboratory og University of California i Berkeley kun en kvart mil væk til 320 bits pr. sekund. Brugerne af systemet var forbløffede og forfærdede.

Internetbrugere over hele landet, der er lige så afhængige af netværket som de fleste af os er af vores telefoner, spekulerede på, hvordan de skulle genoplive det. Van Jacobson fra LBL’s Engineering Division var blandt dem, der blev involveret.

“Netværket var blevet tusind gange langsommere”, husker Jacobson. “Post, der før var gået igennem på få minutter, tog nu en hel dag. Folk begyndte at opgive det. Hele idéen om netværkskommunikation var truet.

“Jeg arbejdede sammen med Mike Karels (fra Berkeley Unix-udviklingsgruppen på University of California i Berkeley). I seks måneder havde vi spurgt, hvorfor internettet fejlede, og vi havde banket hovedet mod en mur. Så en aften på et Berkeley-café kom der et øjeblik af oplysning. Vi vendte spørgsmålet på hovedet. Det virkelige spørgsmål var: “Hvordan har internettet nogensinde fungeret?

“Tænk over det”, siger Jacobson: En arbejdsstation kan sende data med 10 megabit pr. sekund (10 millioner bits), og en router sender dem videre til internettet, som har en kapacitet på 56 kilobit pr. sekund. Man starter med denne flaskehals og skal så kæmpe med tusindvis af mennesker, der bruger netværket samtidig. På denne baggrund, siger han, var det uundgåeligt, at der opstod en trafikprop på internettet.

I takt med at trafikken var steget på Internettet, havde systemets mange brugere været afhængige af, hvad der lignede selvdestruktiv adfærd i deres forsøg på at bryde igennem netværksstoppet. Informationspakker blev sendt til netværket af en computer og efterfølgende sendt tilbage til afsenderen på grund af overbelastningen. Computerne var blevet programmeret til at håndtere dette ved straks at prøve igen og gentagne gange sende beskeden igen, indtil den blev sendt igennem. Jacobson sammenligner situationen med at hælde benzin på en brand.

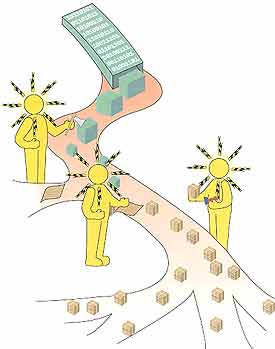

I LIGHED MED PAKKER, DER SENDES MED POSTEN, BLIVER KOMMUNIKATION, DER SENDES VIA ET NETVÆRK, OPDELT I SMÅ PAKKER OG PAKKET IND MED FORSENDELSES- OG SAMLEVEJLEDNINGER, KALDEDE PROTOKOLER |

Løsningen, siger han, var at gøre netværksbrugerne mere høflige.

“Hvis for mange mennesker forsøger at kommunikere på en gang,” forklarer Jacobson, “kan netværket ikke håndtere det og afviser pakkerne og sender dem tilbage. Når en arbejdsstation straks videresender, forværrer det situationen. Det, vi gjorde, var at skrive høflige protokoller, der kræver en lille ventetid, før en pakke videresendes. Alle er nødt til at bruge disse høflige protokoller, ellers fungerer internettet ikke for nogen.”

Jacobson og Karels’ protokoller, som nu er en universel del af internettet, kaldes “Slow Start”. Slow Start undgår overbelastning ved at overvåge netværket og ved, når overbelastning synes nært forestående, at udsætte transmissionen af pakker fra millisekunder til et sekund. Slow Start forsinker transmissionshastighederne på grundlag af faktorer, der omfatter den aktuelle tilgængelige kapacitet på nettet samt et multiplum af transmissionstiden (dvs. afstanden) mellem afsender og den valgte destination. Seks år efter, at Slow Start blev indført, er det stadig muligt at undgå overbelastning af nettet, selv om både nettets hastighed og antallet af brugere er blevet tusind gange større.

For ca. to år siden tog Jacobson og forskere på Xerox’ Palo Alto Research Center (PARC) fat på et projekt, der skulle tilføje lyd- og videokonferencer til internettet. Ligesom med telefonsystemer var lyd/videokonferencer mellem flere parter via computer en gammel, men endnu uopnåelig vision.

Med hensyn til konferencer har et computernetværk som udgangspunkt en iboende fordel i forhold til et telefonsystem. Mens en telefonlinje forbinder to punkter og fører én samtale, forbinder internettet hver enkelt part på linjen og fører flere samtidige “samtaler”. For at understøtte denne enorme informationsstrøm opdeles kommunikationen i små pakker, som blandes i den løbende strøm af pakker, der gennemløber nettet. Hver pakke er pakket indpakket med forsendelses- og samleinstruktioner (kaldet protokoller), som angiver destinationen, returadressen, og hvordan den modtagende computer kan reordne alle pakkerne tilbage til den oprindelige kommunikation.

På grund af de små forsinkelser, der er indbygget i internettet, konkluderede flere forskningsgrupper, der havde til opgave at indføre lyd- og videokonferencer i nettet, at de havde fået en umulig opgave. De rådede til, at der blev bygget et nyt netværk.

“Vi følte, at det var latterligt,” husker Jacobson. “Internettet understøttede kommunikation mellem to Cray-supercomputere, som transmitterer med en gigabit pr. sekund (en milliard bits). Det fungerede også for en person, der sidder ved et tastatur og skriver med 20 bit i sekundet. Denne robusthed og dynamiske rækkevidde virkede for god til at opgive. Så vi kiggede grundigt efter. Der burde ikke have været nogen grund til, at vi ikke kunne lave lyd og video.”

Delays er faktisk mere forstyrrende for folk, der taler, end de er for videokonferencer. Konferencedeltagere kan tolerere et lejlighedsvis stillbillede under en videotransmission, mens stemmer, der høres i ujævne staccato-udbrud, lyder som sludder. Jacobson og Steve Deering fra Xerox PARC koncentrerede sig om at udtænke et system, der kunne bevare internettets globale forbindelsesmuligheder og samtidig give en jævn og hurtig lydstrøm.

For at give lytteren mulighed for at høre kontinuerlig tale tilføjede Jacobson og Deering først en tidsstempel til hver lydpakke. Modtageren læser tidsstemplerne, ordner pakkerne kronologisk og afspiller dem derefter, mens den fortsætter med at modtage og ordne yderligere indkommende pakker til efterfølgende gengivelse. På den måde undgår man at få en “Pig Latin”-tale til at gå ud af hovedet, men man kan ikke håndtere den ujævne karakter af netværkspakkeflowet og de lydbølger, der opstår som følge heraf.

For at afhjælpe dette udnyttede de to forskere forskellen mellem den utrolige hastighed, hvormed netværket flytter pakker, og den relativt lange forsinkelse på to tiendedele til et halvt sekund, som mennesker kan håndtere, uden at samtalen bliver forstyrret. De skabte en algoritme, der beregner, hvor lang tid pakkerne er om at ankomme, og derefter bremser gengivelsen af stemmen nok til at give selv de langsomste pakker tilstrækkelig tid til at nå frem. De forsinkelser i afspilningen, der indføres af algoritmen, er faktisk meget korte, typisk mindre end en tiendedel af et sekund. Takket være de umærkelige kontrollerede forsinkelser, som Jacobson og Deering har indført, er stemmekonferencer mellem internetbrugere med mikrofoner og computerhøjttalere nu almindeligt forekommende.

Siddende på sit kontor i LBL demonstrerede Jacobson, hvordan han er forbundet med netværksbrugere over hele verden. Han loggede ind på internettet og kaldte Lightweight Sessions op, en vinduesgrænseflade med en simpel formular til at annoncere eller tilmelde sig en lyd- eller videokonference. Netværksbrugere har rutinemæssigt adgang til Lightweight Sessions for at få meddelelser om kommende konferencer og for at tilmelde sig de konferencer, der har deres interesse. Nogle konferencer er kun talekonferencer, mens andre omfatter video, som blev udviklet af Xerox PARC-forskere. Under en audio-/videokonference sender små, billige kameraer, der normalt er tilsluttet siden af deltagerens computer, et live-billede af hver enkelt deltager. Jacobsons skærm var opdelt i flere vinduer, hvor det ene vindue viste et billede af den person, der talte. Et andet vindue viste de data, der var under diskussion. Et tredje vindue er planlagt til at blive vist på internettet i den nærmeste fremtid.

Jacobson kalder dette nye grafiske displayvindue for et “whiteboard”. Folk vil kunne bruge det på samme måde som et konventionelt computertegneprogram til at dele oplysninger eller samarbejde om et designprojekt. Alle konferencedeltagere kan se og ændre det, der er afbildet på whiteboardet, eller bladre tilbage til en tidligere version af billedet. Ethvert billede – f.eks. computerstøttede tegninger eller røntgenbilleder – kan også importeres til whiteboard-vinduet.

Hiteboardet er et tegn på den voksende betydning af visuelle data inden for videnskaben.

Stu Loken siger, at stillbilleder og video vil være en integreret del af det meste af den forskning, der udføres på LBL. “Videnskaben oplever en voldsom udbredelse af visuelle data, alt fra skymaps, der kortlægger strukturen af det tidlige univers, til medicinske billeder, der viser neurokemien hos Alzheimer-patienter, til billeder af det menneskelige genom,” siger han.

Loken erkender, at billeder skaber både muligheder og problemer. Der kræves enorme mængder af digital information for at skabe billeder: Et videokamera genererer 30 billeder i sekundet, eller hvad der svarer til mere end 2000 sider ord. Men computere er nu hurtige nok og lagringsenhederne store nok til, at forskerne er begyndt at bruge videokameraer til at optage data til analyse på computer. Denne nye kapacitet medfører et skift i den måde, forskerne udformer eksperimenter på, og åbner nye muligheder for at se, hvad man kan lære.

For at gøre det muligt for forskere at skabe data via video har forskere fra LBL Information and Computing Sciences Division påtaget sig en mangesidet opgave. Bill Johnston står i spidsen for et hold, der skaber ny hardware og software til behandling og analyse af en visuel datastrøm over højhastighedsnetværk. Ideen er at gøre det muligt for en forsker at tage output fra f.eks. et elektronmikroskop og tilslutte denne videostrøm til et netværk lige så rutinemæssigt, som en arbejdsstation kan tilsluttes et netværk i dag.

Anslutning til nettet er kun det første skridt. Johnstons gruppe er dedikeret til udvikling af distribueret videnskabelig databehandling. Indtil nu har ressourcernes placering dikteret videnskabens forløb. Projekterne fortsætter på steder, hvor de rigtige mennesker, eksperimentelle og computerressourcer kan samles. I de distribuerede videnskabelige datamiljøer, som LBL nu er ved at blive banebrydende for, kan maskiner, databaser og mennesker, der er spredt ud over hele kloden, hurtigt og midlertidigt forbindes. F.eks. kan en videostream fra et igangværende eksperiment sendes til en supercomputer til behandling, og den øjeblikkelige analyse kan bruges til interaktiv styring af det eksperimentelle apparat. Eller datastrømmen kan behandles, analyseres og derefter bruges som input i et supplerende eksperiment.

Johnston bemærker, at der allerede findes netværksvideokonferencer, men advarer om, at dette ikke bør forveksles med højhastighedsnetværksoverførsel af videnskabelige videodata. Forskellen ligger i billedets kvalitet.

For at presse videokonferencetransmissioner gennem den stadig snævre internetrørledning er standardtransmissionshastigheden på 30 billeder i sekundet f.eks. blevet reduceret til seks til 12 billeder i sekundet. I stedet for at transmittere en række fulde billeder anvendes der desuden komprimeringsalgoritmer, som kun transmitterer den del af billedet, der er ændret i forhold til det foregående billede. Disse delbilleder sættes derefter sammen til fuldbilleder af software i den modtagende ende. Nettoeffekten er, at folk kan se ordentlige billeder af hinanden, mens de taler, selv om den digitale strømningshastighed er reduceret tusindvis af gange i forhold til en standardvideoudsendelse.

Mens dette fungerer til videokonferencer – der skabes en følelse af nærvær, om end ikke et billede af Ansel Adams-kvalitet – kan videnskabelige data ikke koncentreres på denne måde og overleve.

Forklarer Johnston: “Videodata består typisk af billeder, der er produceret af sensorer, som skubber til teknologiens grænser. Ofte har vi masser af uskarpe billeder med lav kontrast og med træk, som er svære at skelne fra baggrundsstøjen. Hvis vi skal kunne analysere og udtrække oplysninger, må vi ikke have råd til at miste nogen af de oprindelige videodetaljer. Video, der transmitteres via internettet, er blevet komprimeret til 8-16 kilobit pr. sekund. Sammenlign det med et konventionelt monokromt instrumenteringskamera, som genererer 120.000 kilobit pr. sekund.”

Johnstons gruppe bruger laboratorievidenskab som drivkraft til at udvikle teknologi, der i sidste ende er beregnet til masserne. Tag for eksempel LBL-biokemiker Marcos Maestre, som optager små DNA-strenge på video, der vibrerer i et mikroskopisk elektrisk net med henblik på at studere DNA’s fysiske kemi. I øjeblikket lader forskerne DNA’et vibrere, laver et videobånd og sender båndet videre til et animationssystem, hvor der omhyggeligt produceres stillbilleder af hvert enkelt billede. Det tager time efter time at udtrække omkring 200 frames eller syv sekunders data. Derefter scannes billederne ind i en computer billede for billede, som følger og måler DNA-strengens skiftende form, hvilket giver en ny indsigt i dens struktur.

I det distribuerede system, der er under udvikling på LBL, vil forskerne kunne kigge på en arbejdsstationsskærm og se de data, der er udtrukket fra en live-video, selv mens eksperimentet er i gang. Videokameraet vil blive tilsluttet et netværk, hvor en lagerenhed vil gemme billederne og samtidig overføre dem til LBL’s nye supercomputer, et MasPar massivt parallelt behandlingssystem. MasPar kan behandle og analysere et videoinput på 30 billeder i sekundet, hvilket giver en øjeblikkelig visning af data på enhver teknisk arbejdsstation på netværket.

Det kræver desværre mere end blot at sætte systemets komponenter i forbindelse med hinanden for at gøre dette til virkelighed. Når den digitale strøm flyder fra eksperimentet til lagring, analyse og visning, opstår der flere flaskehalse. Før det rå signal, der strømmer ud af det monokrome kamera med 120 000 kilobit pr. sekund, sendes ud på nettet, skal en mellemliggende computer oversætte outputtet til en digital pakke, der er konfigureret til nettet. Den digitale trafik begynder at stivne på dette tidspunkt.

“Når den eneste grund til en computer er at formidle mellem netværket og et kamera,” kommenterer Johnston, “så har man i realiteten skabt et bureaukrati. Computeren gør arbejdet, men ikke effektivt. En computer er designet til at udføre mange opgaver i stedet for denne specialiserede opgave. Det, vi har brug for, er en controller, en computer, der er dedikeret til kun at udføre denne ene opgave. Vi er nu i gang med at bygge en netværkscontroller til et videokamera i et samarbejde med PsiTech Corp. fra Fountain Valley, Californien.”

Spiller bureaukrater og åbner flaskehalse – Johnston siger, at dette er en tilbagevendende opgave for hans gruppe for distribueret databehandling. For eksempel skal data, der ledes gennem et netværk, gemmes i et digitalt arkiv, før de bliver analyseret. Til lagring af de høje datahastigheder fra kilder som video blev der udviklet Redundant Arrays of Inexpensive Disks (RAID) på Berkeley-campus. Den første generation af RAID krævede en mellemcomputer, hvilket bremsede strømmen, så der er blevet bygget en netværkscontroller, og en ny generation, RAID II, er blevet udviklet. RAID II er nu blevet tilsluttet HiPPI, et 800 megabit/sekund-netværk, der typisk bruges til at forbinde supercomputere, og LBL arbejder på at tilslutte det til internettet. Dette arbejde er et samarbejde med flere grupper inden for elektroteknik og datalogi. I et beslægtet projekt, der er finansieret af Department of Energy, har Johnstons gruppe arbejdet sammen med Berkeley-professorerne Domenico Ferrari og Randy Katz og LBL’s Bob Fink og Ted Sopher om at opbygge et gigabit-netværk (milliard bit) af optiske fibre, der forbinder LBL og Berkeley-campus. Alt højhastighedshardware i LBL og på campus er blevet tilsluttet dette netværk, hvilket skaber et lokalt spor til den nationale informationssupermotorvej.

På LBL vil den nye MasPar-computer spille en central rolle i laboratoriets distribuerede datamiljø og åbne døren til æraen med visuelle data. Selv om den vil gøre det muligt at skabe og lagre mængder af billeder, vil forskerne snart støde på en stor hindring. Selv med sine 4 096 processorer, der leverer en maksimal ydelse på 17 000 millioner instruktioner pr. sekund, er der endnu ingen, der ved, hvordan supercomputeren skal instrueres til at finde et bestemt lagret billede.

“At søge i en tekstdatabase efter et ord eller en tegnstreng og at søge i en videodatabase efter et objekt er et meget forskelligt problem”, siger Johnston. “En computer kan let finde alle henvisninger i en tekstdatabase til `fisk’, men der er ingen klar måde at kigge et arkiv af videobilleder igennem og finde alle dem, der indeholder fisk. Vi samarbejder med MasPar Computer Corporation om at udvikle teknologi til at gøre dette.”

Symbolikken i denne mission – at gennemsøge den berømte høstak af billeder og endelig finde nålen – bør ikke overses. For LBL’s dataloger er dette en tid med nært forestående muligheder.

Trafikken på internettet accelererer, og nye spor vokser og tilslutter sig. Siden Clinton og Gore tiltrådte, er der blevet annonceret en kaskade af virksomhedsinvesteringer på flere milliarder dollars i netværksinfrastruktur. Telefon-, kabel-tv- og mobiltelefonselskaber, udgivere og computerproducenter har travlt med at gøre sig gældende. Amerika er ved at blive udstyret med kabler til fremtiden.

På vegne af sine kolleger siger Johnston: “Vi er ved at opleve ændringer i dette land, der er lige så gennemgribende som dem, vores forfædre oplevede ved den industrielle revolutions begyndelse. Inden for det næste årti vil computere, kommunikation og underholdning blive slået sammen. Forskere, læger, forretningsfolk og skolebørn vil være forbundet ikke blot med deres kolleger, men med alle andre. Den måde, vi lærer og interagerer på, er ved at blive revolutioneret.”